Le 10 février 2025, France Info posait la question : « les IA conversationnelles comme ChatGPT sont-elles fiables ? »

Le 16 février, dans une séquence dont le replay semble avoir été supprimé, France Info répondait à la question via une consultante en communication (ancienne candidate LR), qui lors d’un plateau au sujet de l’affaire Bétharram déclarait : « Même si vous demandez aujourd’hui à l’intelligence artificielle son avis sur le sujet, (…) même l’intelligence artificielle exprime qu’il y a une récupération et une instrumentalisation politique de l’affaire Bétharram. »

Ite, missa est. L’IA est donc fiable.

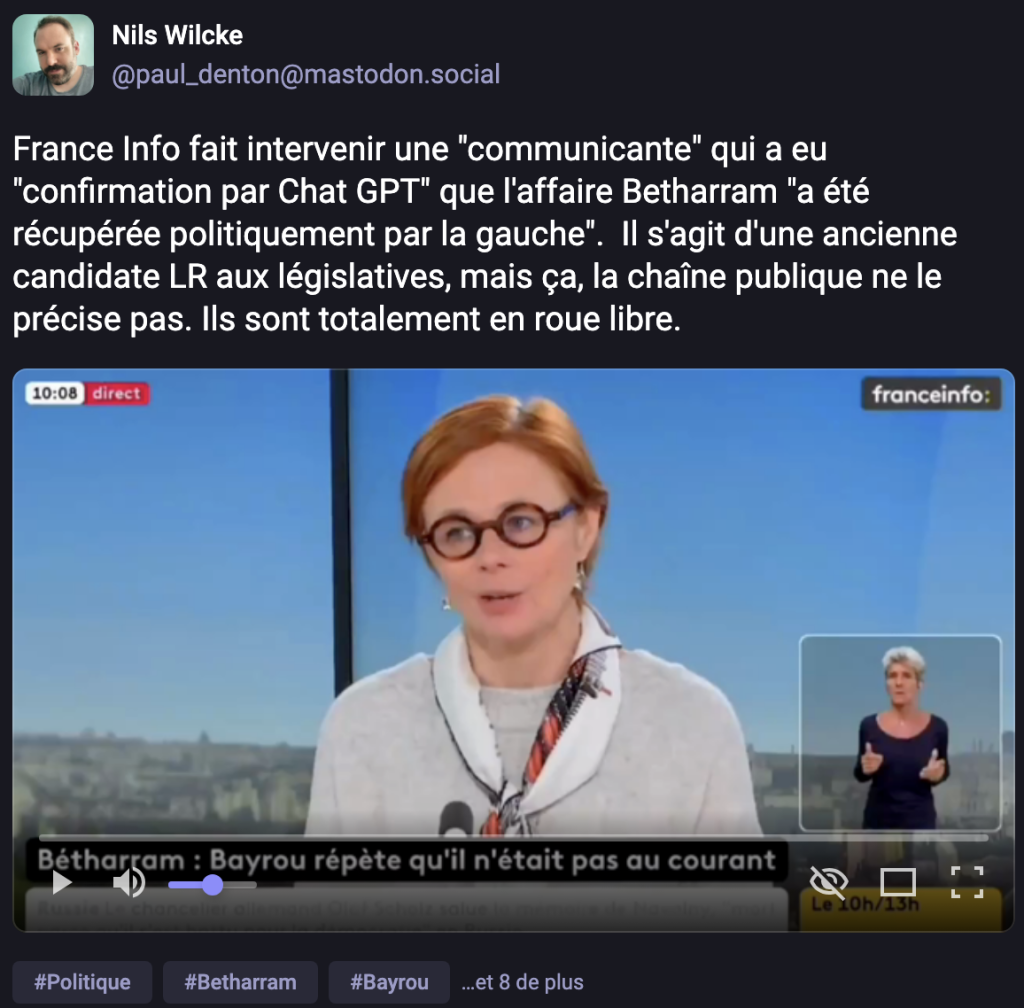

La séquence a été repérée et isolée par le journaliste politique Nils Wilcke depuis ses comptes X et Mastodon. Elle est depuis devenue relativement virale sur différents médias sociaux.

Le nom de la communicante importe peu, elle a depuis fermé son compte X, probablement (et malheureusement) victime de quelques trolls. Ce qui m’intéresse dans cette affaire, c’est le dispositif, le « cadre » informationnel, et ce « momentum » dans la courte histoire des artefacts génératifs grand public.

Le dispositif, le voici. Une chaîne d’information, un fait divers qui devient un fait politique, un.e consultant.e, un plateau de débat, en présence de journalistes. Et le recours à ChatGPT (qui n’est pas directement nommé dans la séquence mais qui est immédiatement convoqué dans l’esprit de toute personne la visionnant).

C’est à ma connaissance la première fois que sur une chaîne d’information, en présence de journalistes, à l’occasion d’un fait divers devenu fait politique, on explique et explicite que l’on peut donc, primo, « demander son avis (sic) » à ChatGPT, et deuxio, considérer que cet avis dispose d’une quelconque valeur de preuve.

Il semble ici important de rappeler deux points fondamentaux.

Primo, ChatGPT (ou n’importe quel autre artefact…

Auteur: Olivier Ertzscheid